De vooruitgang van kunstmatige intelligentie (AI) en taalmodellen, zoals ChatGPT, heeft geleid tot indrukwekkende prestaties op het gebied van mens-machine interactie en automatische contentcreatie. De sleutel tot het maximaliseren van de effectiviteit van deze modellen wordt ook wel ‘prompt engineering’ genoemd. Dit is het proces van ontwerpen en optimaliseren van prompts om zo de gewenste respons te krijgen. In dit blog bespreken we de basisprincipes van prompt engineering. We geven je ook praktische technieken en tips om de best mogelijke interacties met taalmodellen te bereiken. En we kijken naar de uitdagingen en toekomstige ontwikkelingen in dit vakgebied.

Wat is prompt engineering?

Prompt engineering is het proces van het zorgvuldig formuleren van input-vragen (prompts) voor taalmodellen om de gewenste output te verkrijgen. Een prompt is dus feitelijk de opdracht of briefing die je invoert.

Het doel van prompt engineering is om duidelijke, effectieve en nuttige antwoorden te verkrijgen van AI-taalmodellen zoals ChatGPT. Door de prompts te optimaliseren, kunnen we betere resultaten behalen en de potentie van taalmodellen beter benutten.

Prompt engineering technieken en tips

Duidelijkheid en specificiteit

Zorg ervoor dat je prompt duidelijk en specifiek is. Vermijd vage of algemene termen en formuleer je vraag zodanig dat het taalmodel precies begrijpt wat je zoekt.

Voorbeeld

Minder effectief: “Vertel me iets over dieren.”

Effectiever: “Geef me een overzicht van de belangrijkste kenmerken van zoogdieren.”

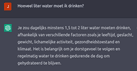

Veronderstellingen en context

Geef indien nodig context en veronderstellingen in je prompt mee, om het taalmodel te helpen de situatie beter te begrijpen.

Voorbeeld

Minder effectief: “Hoeveel liter water moet ik drinken?”

Effectiever: “Als volwassene die gemiddeld 70 kg weegt en een zittend beroep heeft, hoeveel liter water moet ik dagelijks drinken?”

Incrementele informatie

Probeer een reeks van aanwijzingen of vragen te gebruiken om het taalmodel geleidelijk meer informatie te geven. Dat kan helpen bij het verfijnen van het antwoord.

Voorbeeld

Eerste vraag: “Wat zijn de belangrijkste kenmerken van impressionistische schilderkunst?”

Vervolgvraag: “Kun je enkele beroemde impressionistische schilders en hun bekendste werken noemen?”

Beperk antwoord lengte

Geef, indien mogelijk, een gewenste lengte of limiet voor het antwoord, zodat het taalmodel beknopt en to-the-point blijft.

Voorbeeld: “Geef een korte samenvatting van de belangrijkste gebeurtenissen in de Franse Revolutie in ongeveer 100 woorden.”

Meerdere pogingen

Probeer verschillende formuleringen van je prompt om te zien welke het beste werkt, en experimenteer met synoniemen en alternatieve zinsconstructies.

Voorbeeld

Eerste poging: “Hoe kan ik een duurzamer leven leiden?”

Tweede poging: “Wat zijn effectieve manieren om mijn ecologische voetafdruk te verkleinen?”

Uitdagingen in prompt engineering

Bevooroordeeldheid en nauwkeurigheid

Taalmodellen kunnen soms bevooroordeelde of onnauwkeurige antwoorden geven op basis van hun trainingsgegevens. Het is belangrijk om kritisch te blijven over de output en te controleren op eventuele fouten.

Onvoorspelbare respons

Taalmodellen kunnen soms verrassende of onverwachte antwoorden geven. Prompt engineering helpt bij het sturen van het model naar de gewenste output. Maar het blijft een uitdaging om volledige controle te hebben over de gegenereerde respons.

Balanceren tussen creativiteit en beperking

Hoewel het belangrijk is om het taalmodel te begeleiden naar de gewenste output, willen we ook niet de creativiteit van het model te veel beperken. Het vinden van de juiste balans tussen het sturen van het model en het toestaan van creatieve en diverse antwoorden is een uitdaging.

Vage of ambigue prompts

Als een prompt niet duidelijk of te open is, kan het taalmodel moeite hebben met het genereren van een geschikt antwoord. Het is belangrijk om prompts zorgvuldig te formuleren om de kans op relevante en nauwkeurige antwoorden te vergroten.

Aanpassen aan nieuwe domeinen

Taalmodellen zijn getraind op basis van algemene gegevens. Dat betekent dat ze mogelijk niet goed presteren in zeer gespecialiseerde of technische domeinen. Het kan een uitdaging zijn om prompts zo te ontwerpen dat het model de juiste context en expertise begrijpt.

Herhaling

Taalmodellen kunnen de neiging hebben om zichzelf te herhalen of irrelevante informatie te genereren. Het is belangrijk om rekening te houden met deze uitdaging bij het ontwerpen van prompts en eventueel het model opnieuw te trainen met aangepaste gegevens.

Lokalisatie en meertaligheid

Taalmodellen zijn meestal getraind op een breed scala aan talen en culturen, maar ze presteren mogelijk niet even goed in alle talen. Het kan een uitdaging zijn om prompts te ontwikkelen die rekening houden met taalkundige en culturele verschillen en tegelijkertijd de gewenste output genereren.

Ethische overwegingen

Bij het ontwerpen van prompts moeten we rekening houden met de ethische implicaties van de gegenereerde output. Dit omvat het vermijden van bevooroordeelde, aanstootgevende of ongepaste inhoud, en ook het waarborgen van de privacy van de gebruikers.

Om deze uitdagingen aan te pakken, zijn er verschillende best practices voor prompt engineering die we kunnen volgen. Zo kunnen we bijvoorbeeld prompts iteratief ontwikkelen en testen, zorgvuldig geformuleerde vragen gebruiken en technieken toepassen zoals instructies geven aan het model, contextuele informatie bieden en beperkingen stellen. Bovendien is het waardevol om samen te werken met domeinexperts om de kwaliteit en relevantie van de output te waarborgen, en om ethische richtlijnen te ontwikkelen voor verantwoord gebruik.

Toekomstige ontwikkelingen in prompt engineering

Adaptieve prompts

Naarmate taalmodellen geavanceerder worden, kunnen we adaptieve prompts ontwikkelen die zich aanpassen aan de context en behoeften van de gebruiker, waardoor nog nauwkeurigere en relevantere antwoorden mogelijk zijn.

Persoonlijke aanpassing

In de toekomst kunnen taalmodellen en prompt engineering-technieken worden aangepast aan individuele gebruikers, rekening houdend met hun persoonlijke voorkeuren, stijl en kennisniveau.

Integratie met andere AI-technologieën

Prompt engineering kan worden gecombineerd met andere AI-technologieën, zoals beeldherkenning en geavanceerde data-analyse, om nog krachtigere en meer gevarieerde toepassingen te creëren.

Verbeterde lokalisatie en meertaligheid

Naarmate taalmodellen beter worden in het omgaan met meerdere talen en culturen, kunnen we geavanceerdere prompt engineering-technieken ontwikkelen die rekening houden met taalkundige en culturele verschillen, waardoor een betere lokalisatie en meertaligheid mogelijk wordt.

Ethische richtlijnen en standaarden

Het ontwikkelen van ethische richtlijnen en standaarden voor prompt engineering wordt steeds belangrijker naarmate taalmodellen een grotere rol spelen in ons dagelijks leven. Dit kan helpen om het verantwoord en ethisch gebruik van AI-taalmodellen te waarborgen. En te voorkomen dat ze schade aanrichten of misbruikt worden.

Ben jij nieuwsgierig naar de laatste ontwikkelingen rondom AI en taalmodellen? Wil je weten welke innovaties rondom kunstmatige intelligentie van belang kunnen zijn voor jouw bedrijf? Of wil je gewoon bij de coffee corner kunnen meepraten over de revolutie die artificial intelligence wereldwijd heeft ontketend? Luister dan snel naar onze nieuwe podcast: Enrise AI.

Conclusie

Prompt engineering is een cruciaal aspect van het werken met geavanceerde taalmodellen zoals ChatGPT. Door het optimaliseren van de prompts die we gebruiken, kunnen we betere resultaten behalen en het volledige potentieel van deze technologie benutten. Naarmate taalmodellen blijven evolueren, zullen prompt engineering-technieken ook moeten evolueren om bij te blijven met de veranderende mogelijkheden en uitdagingen. Door samen te werken met domeinexperts en ethische richtlijnen te ontwikkelen, kunnen we zorgen voor een verantwoord gebruik van AI-taalmodellen en hun impact op de samenleving maximaliseren.