Bij Enrise openden we gisteren onze deuren voor CodeCuisine®LIVE, de kwartaallijkse kennissessie voor klanten, relaties en geïnteresseerden. Met het thema Data. Search & Science gaven we een kijkje in de keuken van big content en big data.

Met CodeCuisine®LIVE nodigen we een of meerdere gastsprekers uit om de bezoekers bij te praten over nieuwe ontwikkelingen op het kruispunt van techniek en bedrijfsvoering. Gastspreker Rob Hoeijmakers liet ditmaal de digitale setup zien van ‘s werelds grootste kabelmaatschappij Liberty Global.

Marketing verbinden met flexibele technologie

Liberty Global is operationeel in Europa met onder andere Ziggo in Nederland, Unitymedia in Duitsland en Virgin Media in de UK. Ze bedienen 29 miljoen klanten in 14 landen. Voor online activiteiten betekenen dat al snel ruim 5000 pagina’s en 250 miljoen pageviews per maand. Dat is 100 Terabyte aan dataverkeer, videostreams uitgezonderd.

Content beheren vanuit 1 centrale plek

Al die contentpagina’s worden beheerd door een redactie per land en merk. Elk merk doet dat voor zich, maar overkoepelend is de layout vastgelegd in een templating system. De content wordt gemaakt en beheerd in de Adobe Experience Manager.

Rob vertelde hoe de paginasjablonen zijn opgebouwd uit componenten, bouwstenen die net als Legosteentjes samen nieuwe componenten kunnen vormen. Zo maakt de redactie van bijvoorbeeld UPC een actiepagina, met componenten als beeld, tekst en een knop. Die set aan componenten is vervolgens herbruikbaar voor de merken in de andere landen.

Kennis en ervaring managen

Werken op zo’n grote schaal met bergen content en consistent blijven in je technische uitvoering vraagt om een goede aanpak. Dat heb je niet van vandaag op morgen, maar moet groeien in je organisatie. Dat lukt alleen als je kennis deelt, middelen beschikbaar stelt en mensen met goede ideeën bijeen brengt.

Rob legt uit hoe Liberty Global trainingspakketten heeft opgesteld om nieuwe medewerkers zich snel de aanpak eigen te kunnen maken. Alle documentatie is ontsloten met een centrale wiki en elk kwartaal organiseren ze interne evenementen waar mensen met elkaar sparren en kennis uitwisselen over de user experience van het platform.

Aan de hand van een demo geeft Liberty Global ons een kijkje in hun Adobe Experience Manager, waarbij je goed kunt zien hoe de pagina’s op basis van componenten eenvoudig aangemaakt en gewijzigd worden. Die flexibele aanpak maakt het ook mogelijk om andere technieken in de site onder te brengen, zoals de sitesearch van Enrise. Elk land kan specifieke instellingen en inrichtingen doen om de search zo ideaal mogelijk te laten werken.

Don’t try to standardise. Harmonize. – Rob Hoeijmakers, Liberty Global

Lessons learned

Wat Rob Hoeijmakers de bezoekers van CodeCuisine®LIVE wil meegeven is dat als je op zoek bent naar contentmanagement op dit niveau, dan je op zoek moet nara de harmonie van standaardpakketten en maatwerk. Hoewel de Adobe Experience Manager een standaardpaket is, heeft Liberty Global er wel voor gezorgd dat maatwerktoepassingen mogelijk blijven. Zo kun je snel itereren en innoveren in een markt waar ontwikkelingen supersnel gaan, zonder dat je vast zit aan een systeem dat niet meebeweegt. Door al in een vroeg stadium de vrijheid van maatwerk te kiezen, heb je op de langere termijn meer profijt van je keuze.

Big data

Na een korte break gaan we verder met spreker Hein Souman. Hein is product owner binnen het search- en datateam binnen Enrise. Hij neemt het publiek mee in de vraag naar wat big data feitelijk is. Wat is big? Wannéér is het big? Hein opende met 3 getallen die later zouden terugkomen?

- 3 is big.

- 800 is klein.

- 760 miljard is relatief.

Volume, Variety en Velocity

Bij big data denken de meeste mensen aan grote hoeveelheden informatie, uitgedrukt in bijvoorbeeld terabytes en petabytes. Maar dat maakt de datawolk nog niet big. Het gaat erom wat je ermee doet, dat maakt informatie big.

Het eerste getal dat Hein noemde, ‘3 is big’, slaat op de drie aspecten die bepalen wat data is en wanneer het big is.

- Het Volume zegt iets over de omvang, in bijvoorbeeld gigabytes, terabytes en petabytes

- De Variety gaat over het type data. Zijn het tekstbestanden en pdf’s? Is het een databas? Of gaat het om data in images, audio, sociale interacties of data uit slimme apparaten?

- Als derde gaat het over snelheid van dataverwerking, de Velocity. Het maakt nogal uit of de verwerking ‘s nachts plaatsvindt, in batches of realtime.

Pas als hiervan twee of drie waarden samenvallen, spreek je over big data. Dus ook als je weinig volume hebt, maar wel grote variatie in data en je wilt die realtime ontsluiten, dan spreek je over big data.

Calculeren binnen een seconde

Hein geeft een voorbeeld van een leaseprijscalculator die we bij Enrise ontwikkelden voor Terberg Leasing. Met 15000 auto’s is dan niet echt big data te noemen. Maar Hein legt uit dat big data dichterbij is dan je denkt. Want als koper ben je weliswaar op zoek naar maar 1 auto, maar dat wordt snel anders als je een calculator ontwikkelt. Want die ene auto betekent een keuze uit merken, modellen, typen, accessoires en opties. Daarbij komen zaken als belastingtarieven, klantkortingen en bijtellingen. De variatie in keuzemogelijkheden is enorm.

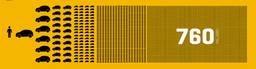

Met een eenvoudige rekensom toont hij dat je met de zoektocht naar die ene auto tot wel 760 miljard unieke combinaties kunt maken. Toch is zo’n getal op zich nog geen big data. Dat wordt het wel als je het doel hebt om uit die 760 miljard combinaties een handvol resultaten te tonen binnen 800 milliseconden.

Dat is een proces dat voorheen ‘s nachts plaatsvond, maar nu realtime kan. Voor de eindgebruiker is dat wellicht niet schokkend, maar voor bedrijven is een nacht werk reduceren tot een split-second een enorm verschil in werkwijze en mogelijkheden.

Tips voor aanpak van bigdataprojecten

Hein besluit zijn verhaal met drie tips en learnings die je kunt toepassen bij projecten waar big data onderdeel van is.

- Wees Agile. Kijk opnieuw tegen daadwerkelijke problemen aan en los die met nieuwe inzichten op. Dat maakt je op data gebaseerde applicatie efficiënt in het gebruik.

- Blijf elk moment de performance meten en monitoren. Door in een vroeg stadium vertragingen te tackelen, heb je een het eind van de rit nog steeds een supersnelle gebruikerservaring. Achteraf is dit moeilijk te realiseren.

- Geautomatiseerd functioneel regressietesten blijft essentieel. Dus niet alleen blind varen op data en monitoring, maar ook echt testen met vreemde data en wat-als-scenario’s. Zo hou je grip op je data en kun je tijdig bijsturen.

CodeCuisine®LIVE werd afgesloten met een walking diner voor alle gasten, verzorgd door de Enrise-buren van restaurant Dara.